Un nombre croissant d'événements en direct tels que des conférences, des réunions, des conférences, des débats, des émissions de radio et de télévision, etc. sont aujourd'hui diffusés en direct sur les chaînes vidéo et les réseaux sociaux. Ces événements sont transmis en temps réel à un large public, sur tous types d'appareils et partout dans le monde. Sous-titrage et traduction en direct1 sont considérées comme essentielles pour garantir que ces événements atteignent un public international croissant.

Comment optimiser le confort et l'expérience de compréhension d'un public aussi large soulève la question du multilinguisme dont nous discutons dans ce billet.

Dans le contexte de la prochaine présidence française de l'Union européenne en janvier 2022, SYSTRAN a développé un outil appelé Speech Translator pour le sous-titrage en temps réel et la traduction de discours à un seul orateur ou de réunions à plusieurs orateurs. En commençant par le français ou l'anglais comme langue parlée source, Speech Translator :

- transcrit le discours original, en partenariat pour cette tâche avec la reconnaissance vocale automatique Vocapia2,

- ponctue et segmente la sortie ASR (reconnaissance automatique de la parole), en mettant cette transcription automatiquement formatée et corrigée à la disposition de l'auditeur humain (transcription/sous-titrage de la parole),

- exécute simultanément la traduction automatique (MT) alimentée par nos modèles de traduction de la meilleure qualité vers les langues de l'Union européenne (traduction/sous-titrage de la parole),

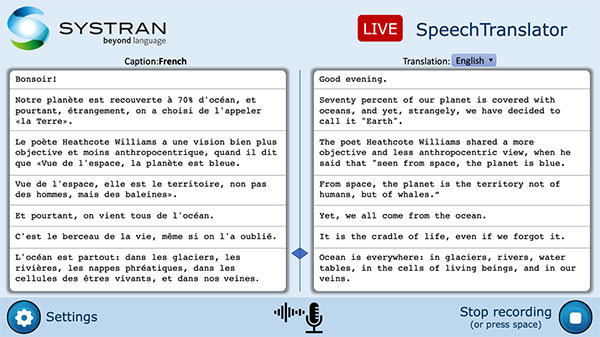

tout cela avec la latence la plus faible et dans une interface dédiée et conviviale. La tâche ressemble beaucoup à l'interprétation simultanée, qui effectue des traductions multilingues en temps réel. La figure suivante montre une capture d'écran de notre interface système ST en direct où les légendes (à gauche) ainsi que les traductions anglaises correspondantes (à droite) sont affichées.

SpeechTranslator : Système de traduction vocale en direct.

Concentrons-nous sur la mise en place de la traduction en direct d'un discours français en anglais, pour le rendre accessible à un public plus large.

Compte tenu du signal de parole en français, le système produit d'abord des transcriptions ASR qui sont ensuite segmentées, corrigées et formatées sous forme de légendes en français et traduites en anglais. La figure ci-dessous illustre notre pipeline ST. Les systèmes récents effectuent la traduction vocale selon une approche directe où un seul réseau est chargé de traduire le signal vocal d'entrée en texte dans la langue cible. Cependant, malgré la simplicité architecturale et la propagation minimale d'erreurs de ces nouveaux systèmes, les solutions en cascade sont encore largement utilisées, principalement en raison du problème de rareté des données que posent les approches directes puisque la plupart des paires de langues manquent de ressources parallèles (traductions de signaux de parole/texte). En outre, les applications industrielles affichent généralement des transcriptions vocales, à côté des traductions (comme dans notre figure précédente), ce qui rend les approches en cascade plus réalistes et pratiques.

Dans le cadre de la cascade standard, les chercheurs ont rencontré plusieurs difficultés, notamment :

- Adaptation aux transcriptions ASR : Les hypothèses ASR présentent des caractéristiques très différentes de celles des textes utilisés pour former les réseaux de traduction automatique neuronale (NMT). Alors que les modèles NMT sont souvent formés avec du texte propre et bien structuré, les énoncés oraux contiennent de multiples disfluences et erreurs de reconnaissance qui ne sont pas bien modélisées par les systèmes NMT. En outre, les systèmes ASR ne prédisent généralement pas correctement les limites des phrases ou les majuscules, car ils ne sont pas accessibles de manière fiable en tant qu'indices acoustiques. Les systèmes ASR classiques segmentent la parole d'entrée en utilisant uniquement des informations acoustiques, c'est-à-dire des pauses dans la parole, qui diffèrent considérablement des unités attendues par les systèmes MT classiques.

- Traductions à faible latence : Les systèmes utilisant des segments de parole plus longs peuvent couvrir plusieurs phrases. Ce qui entraîne des retards de traduction importants, ce qui nuit à l'expérience de lecture. Les délais de traduction limités sont généralement obtenus en démarrant la traduction avant la réception de la totalité de l'entrée audio, une pratique qui pose d'importants défis de traitement.

Dans ce qui suit, nous donnons plus de détails sur les défis rencontrés dans la mise en œuvre de notre système ST et décrivons les mesures prises pour résoudre ces problèmes.

Adaptation aux transcriptions ASR

De nos jours, une grande quantité de sources audio sont produites quotidiennement. Les systèmes ASR permettent d'utiliser ce contenu vocal dans de multiples applications (indexation, catalogage, sous-titrage, traduction, production de contenu multimédia, etc.). Les détails dépendent des systèmes ASR individuels, mais leur sortie, communément appelée transcription, est généralement constituée de texte brut enrichi de codes temporels. La figure ci-dessous illustre un exemple de transcription ASR.

Notez les codes temporels et les scores de confiance pour chaque enregistrement. Les enregistrements de latence indiquent des pauses dans la parole. Ensuite, nous énumérons quelques-unes des caractéristiques les plus difficiles présentes dans les discours considérés dans notre projet (discours politiques français). L'image suivante illustre deux transcriptions contenant des erreurs et des disfluences typiques.

| en complément des tests ça l ? hiver la grande nouveauté de la reprise olivier veran le y reviendra sera le déploiement des tests automatiques |

| dEpuis nous avons euh chercherr une solution qui puisse être acceptéeé par les groupes politiquese à propos de la 3ème partie de cet amendement |

- Limites de phrase. Les unités de parole contenues dans les transcriptions ne correspondent pas toujours aux phrases telles qu'elles sont établies dans le texte écrit, alors que les limites des phrases fournissent une base pour le traitement ultérieur du langage naturel.

- Ponctuation. En partie à cause de l'absence de limites de phrases, aucun signe de ponctuation n'est produit par les systèmes ASR en mode temps réel, une caractéristique clé pour la lisibilité des transcriptions vocales.

- Capitalisation. Les transcriptions ne comportent pas de majuscules correctes. Une tâche de mise en majuscules est nécessaire pour attribuer à chaque mot les informations de majuscules et de minuscules correspondantes, généralement en fonction du contexte. C'est le cas des premiers mots de nos exemples.

- Représentation numérique. Les nombres constituent un défi pour la transcription, en particulier la segmentation des nombres. Voir par exemple l'exemple de notre figure précédente où le nombre prononcé ?2001 ? est mal transcrit comme une séquence de trois nombres : 2, 1000 et 1. Les deux transcriptions peuvent être possibles, seule l'utilisation du contexte peut aider à choisir la bonne.

- Divergences. Les disfluences de la parole telles que les hésitations, les pauses remplies, les syllabes allongées, les pauses silencieuses au sein d'une phrase, les répétitions sont parmi les marqueurs les plus fréquents de spontanéité. Les disfluences sont la source la plus importante de divergences entre la parole spontanée et le texte. Une hésitation (euh) est transcrite dans notre exemple précédent.

- Erreurs de reconnaissance. Les systèmes ASR sont sujets aux erreurs. Il existe plusieurs types de méconnaissance. Pour ce travail, nous considérons principalement les erreurs dues aux homophones, les énoncés manqués, les mots insérés à tort et les changements d'inflexion.

- Homophone : (ça l ? hiver ? salivaires)

- Mot inséré par erreur : (on)

- Modifications d'inflexion : (chercher ? chercher ; accepté ? accepté ; politique ? politiques)

L'adaptation est réalisée en enrichissant les transcriptions vocales et les ensembles de données MT afin qu'ils se ressemblent davantage, améliorant ainsi la robustesse du système à la propagation d'erreurs et améliorant la lisibilité des résultats pour les humains. Nous avons pris des bitextes français/anglais dans le domaine du discours politique et injecté aléatoirement du bruit dans le côté français, simulant des erreurs générées par un système ASR, pour obtenir des textes français/français/anglais propres et bruyants que nous avons utilisés pour alimenter nos modèles.

Traductions à faible latence

Alors que les systèmes MT actuels fournissent une qualité de traduction raisonnable, les utilisateurs de systèmes ST actifs doivent attendre que la traduction soit livrée. Cela réduit considérablement l'utilité du système dans la pratique. Les délais de traduction limités sont généralement obtenus en démarrant la traduction avant la réception de la totalité de l'entrée audio, une pratique qui pose d'importants défis de traitement.

Nous nous attaquons à ce problème en décodant la sortie ASR chaque fois que de nouveaux mots deviennent disponibles. La figure suivante illustre les étapes d'inférence effectuées par nos réseaux lors du décodage de la transcription ASR de l'énoncé français: ?le palais est vide (pause) le roi est parti il revient ?.

Colonne FR indique (en rouge) les mots sortis par l'ASR à chaque pas de temps t. Colonnes fr et fr indiquer la sortie correspondante de nos modèles (respectivement FR2fr et FR2en) au pas de temps t.

Notez que les flux d'entrée (colonne FR) supprimer les séquences de préfixe lorsqu'un fin de phrase (eos) est prédit par le modèle suivi de N mots (N = 2 dans notre example). Cela établit un juste équilibre entre la flexibilité et la stabilité des choix de segmentation, permettant au modèle de reconsidérer sa prédiction initiale tout en garantissant le maintien de choix cohérents. Remarquez aussi qu'après avoir prédit (eos)Les mots sortis par nos modèles sont constitués des mêmes mots sortis par l'ASR. Cela nous permet d'identifier le préfixe à utiliser lors de la construction de nouvelles entrées (chaînes soulignées). Le préfixe contient également le dernier jeton prédit pour la phrase précédente suivi de (eos) prédire la casse du mot initial de chaque phrase. Notez que les légendes françaises sont affichées dans la colonne fr sont transmis à notre modèle fr2en (après avoir retiré le (eos) et les mots suivants (lorsqu'ils sont disponibles) pour générer les hypothèses anglaises finales.

Nous avons soigneusement préparé nos ensembles de données d'entraînement à la suite de l'injection de bruit précédente et des astuces de faible latence qui reproduisent le bruit présent dans les données considérées pour inférence.

Résultats

Pour l'évaluation, nous utilisons des jeux de tests provenant de deux corpus ST multilingues, Europarl ST3 et MTEDX4 (TEDx multilingue). Le tableau suivant illustre les résultats de l'UEBL obtenus par les traductions anglaises suivant trois pipelines différents :

- fr2fr traduit des hypothèses ASR françaises avec un modèle formé à partir de texte bien structuré (sans adaptation)

- FR2fr+fr2en concatène le modèle de nettoyage avec un modèle de traduction construit à partir de données bien structurées

- FR2en traduit directement les hypothèses ASR françaises en texte anglais propre.

Comme prévu, le fr2fr Le modèle, formé sur des données parallèles propres, présente les pires résultats. Les différences dans les ensembles de données de formation et d'inférence ont une incidence significative sur le rendement. En ce qui concerne les modèles appris en utilisant des données bruitées, les meilleures performances de l'UEBL sont obtenues par FR2en modèle. Nous formulons cette hypothèse FR2fr+fr2en souffre d'une propagation d'erreurs, ce qui signifie que les erreurs introduites dans le premier module FR2fr ne peuvent pas être récupérées par le module fr2en. Malgré son score BLEU inférieur, le modèle FR2fr+fr2en a l'avantage de produire des sous-titres en français, ce qui est un atout important pour certaines applications de l'industrie, et dans notre cas actuel de sous-titrage et de traduction en direct.

En termes de latence, le cadre présenté fournit également des traductions avec des taux de retard très faibles. Chaque nouveau mot fourni par l'ASR produit une nouvelle hypothèse de sous-titrage et de traduction, qui est immédiatement affichée à l'utilisateur. Même si le segment en cours de décodage peut parfois fluctuer (les changements de traduction lors de l'inclusion de mots supplémentaires), dans la pratique nous avons rencontré des fluctuations très limitées, impactant toujours les derniers mots des hypothèses en cours de décodage.

Elise Bertin-Lemée, Guillaume Klein et Josep Crego, SYSTRAN Labs

[1] Dans ce travail, nous utilisons légende se référer à un texte écrit dans la même langue que l'audio et sous-titre traduit dans une autre langue.

[2] https://www.vocapia.com/voice-to-text.html

[3] https://www.mllp.upv.es/europarl-st/

[4] http://www.openslr.org/100/